Depuis le 30 novembre 2022, plus un jour ne se passe sans que l’on ne parle dans les médias de ChatGPT et des IA génératives, le phénomène technologique de ce début d’année.

Pourquoi un tel emballement? Selon certains experts, la mise à disposition du public de ces outils qui permet une discussion en langage naturel entre un humain et une intelligence artificielle spectaculaire sera comparable dans son impact à l’arrivée d’Internet ou des smartphones. Rien que ça.

- Et si ChatGPT réinventait notre rapport au web?

- Découvrir les secrets de la “soupe primordiale” de ChatGPT

- IA et recherche: au-delà de la boîte noire

- Les outils évoluent, la formation aussi

- « Pour les arts, je vois plus d’opportunités que de risques »

- Quand l’IA invente, qui est l’inventeuse?

- « La machine n’est jamais responsable »

Au commencement était le GPT

Si le potentiel de ChatGPT semble en effet considérable, ses limites sont elles aussi rapidement atteintes dans certains cas. Mais au-delà de cet outil lui-même et de ses concurrents, c’est la place que les algorithmes d’intelligence artificielle sont appelés à prendre dans la société qui se retrouve soudain propulsée au cœur des débats.

ChatGPT repose sur GPT-3, un «modèle de langage» lancé par la société OpenAI en 2020. Se basant sur un énorme corpus de pages web comportant plusieurs dizaines de milliards (!) de mots, ce modèle utilise des statistiques pour construire des phrases en fonction de la probabilité que des mots soient utilisés ensemble ou dans un certain ordre. Il est à ce jour le plus performant des outils de compréhension et de génération de phrases en langage naturel et fonctionne dans plusieurs langues.

«Si GPT-3 existe déjà depuis plusieurs années, c’est toutefois ChatGPT qui l’aura propulsé auprès du grand public. La communauté scientifique ne s’attendait pas à ce que ce soit si rapide», reconnaît Antoine Bosselut, professeur assistant au Laboratoire de traitement du langage naturel de l’EPFL.

Aujourd’hui, ce sont encore plutôt les geeks, les jeunes et la population intéressée par les nouvelles technologies qui se sont emparés de l’outil afin de le tester. Mais cela a tout de même représenté plusieurs millions de comptes créés dans les jours qui ont suivi la mise en ligne de ChatGPT. Et surtout, cela a déclenché une véritable tornade médiatique – mettant en lumière non seulement les capacités de ce type d’intelligence artificielle, mais aussi ses limites et ses dangers – et les prémices d’une guerre économique entre Google et Microsoft pour commencer.

La communauté scientifique ne s’attendait pas à ce que ce soit si rapide”

Commentaire: Une ou plusieurs images de référence peuvent être incluses sous forme d'URL dans les prompts. On voit ici comment le générateur d’image reconnaît les éléments de composition globaux (montagnes, lac, campus) et les combine avec les autres paramètres pour produire cette vision onirique de l’EPFL, dont l’architecture ne ressemble guère à la réalité.

© Créée avec "Midjourney" par Alexandre Sadeghi

L’adopter ou s’en détourner ?

Selon Silvia Quarteroni, responsable de l’équipe innovation au Swiss Data Science Center (SDSC) de l’EPFL et de l’EPF de Zurich, l’impact de ChatGPT et plus généralement des techniques d’IA générative sur les milieux économiques sera important. «C’est particulièrement vrai pour tous les usages gourmands en textes, résumés, synthèses, rapports, ou premières ébauches de slogan par exemple, explique-t-elle. Même si l’outil n’est pas toujours aussi performant que l’humain, il offre souvent des résultats utilisables. Ne pas utiliser les technologies d’IA générative pourra entraîner pour des entreprises ou des organisations une perte de compétitivité, une opportunité ratée dans quasiment tous les secteurs où il y a du texte à produire. Il en sera de même pour les images car certaines de ces technologies, par exemple DALL-E, sont multimodales : on peut les utiliser pour produire une image à partir d’un texte et une légende à partir d’une photo.»

Il faudra toutefois un temps d’adaptation pour savoir si ce sont de réelles opportunités ou au contraire un risque de perte de substance. Dans tous les cas, des conseils et des formations seront indispensables. «Le rôle du SDSC est d’amener ce concept au public, aux entreprises, de les aider à ne pas rater ce tournant, reprend Silvia Quarteroni. OpenAI domine aujourd’hui avec ChatGPT, mais d’autres éditeurs proposent d’autres outils similaires au sein des GAFAM. La concurrence existe et les entreprises auront le choix entre différents modèles accessible économiquement selon leurs besoins.»

À l’EPFL également, le Center for Intelligent Systems (CIS) fédère les efforts de recherche menés dans les domaines du machine learning, de l’intelligence artificielle et de la robotique. «Son pilier de recherche AI4Science/Science4AI s’articule autour de l’interaction entre la façon dont l’IA changera la recherche scientifique et celle dont les sciences fondamentales peuvent aider à comprendre les systèmes complexes d’IA», explique Pierre Vandergheynst, directeur académique du CIS. «Les grands modèles de langage comme ChatGPT ne sont que le début de la manière dont les systèmes d’IA auront un impact sur notre société. L’EPFL est bien positionnée à travers le CIS pour former ses futurs diplômés dans les domaines du ML, de l’IA et de la robotique, pour faire avancer la recherche dans les domaines connexes et pour soutenir l’industrie dans le transfert de ces nouvelles technologies vers des applications pour la société», ajoute Jan Kerschgens, directeur exécutif.

Commentaire: Une ou plusieurs images de référence peuvent être incluses sous forme d'URL dans les prompts. On voit ici comment le générateur d’image reconnaît les éléments de composition globaux (montagnes, lac, campus) et les combine avec les autres paramètres pour produire cette vision onirique de l’EPFL, dont l’architecture ne ressemble guère à la réalité.

© Créée avec "Midjourney" par Alexandre Sadeghi

Ne pas utiliser les technologies d’IA générative pourra entraîner pour des entreprises ou des organisations une perte de compétitivité, une opportunité ratée”

Sylvia Quarteroni // style Van Gogh © Créée avec « Midjourney » par Alexandre Sadeghi

Les capacités de ChatGPT provoquent aussi beaucoup de remous dans les milieux de l’éducation, tant l’outil se montre performant pour rédiger un examen en lieu et place des personnes censées démontrer leurs capacités. Comment s’y préparer? Les approches divergent, mais les enseignants de l’EPFL ne voient pas forcément cela d’un mauvais œil.

De nombreux autres champs d’application, dont certains sont détaillés dans les pages qui vont suivre, pourraient eux aussi connaître de profonds bouleversements. Même si les algorithmes font déjà partie de la boîte à outils des scientifiques et des professionnels depuis plusieurs années. Ils sont devenus incontournables dans des domaines aussi variés que la recherche, la médecine, l’art ou l’architecture, pour ne citer qu’eux. Aujourd’hui, on ne peut plus faire l’impasse sur les questionnements éthiques et juridiques que pose le recours croissant à la machine dans nos vies, que ce soit dans la prise de décision ou la répartition des tâches.

Compagnes ou concurrentes, à nos sociétés de décider notre rapport aux intelligences artificielles. ■

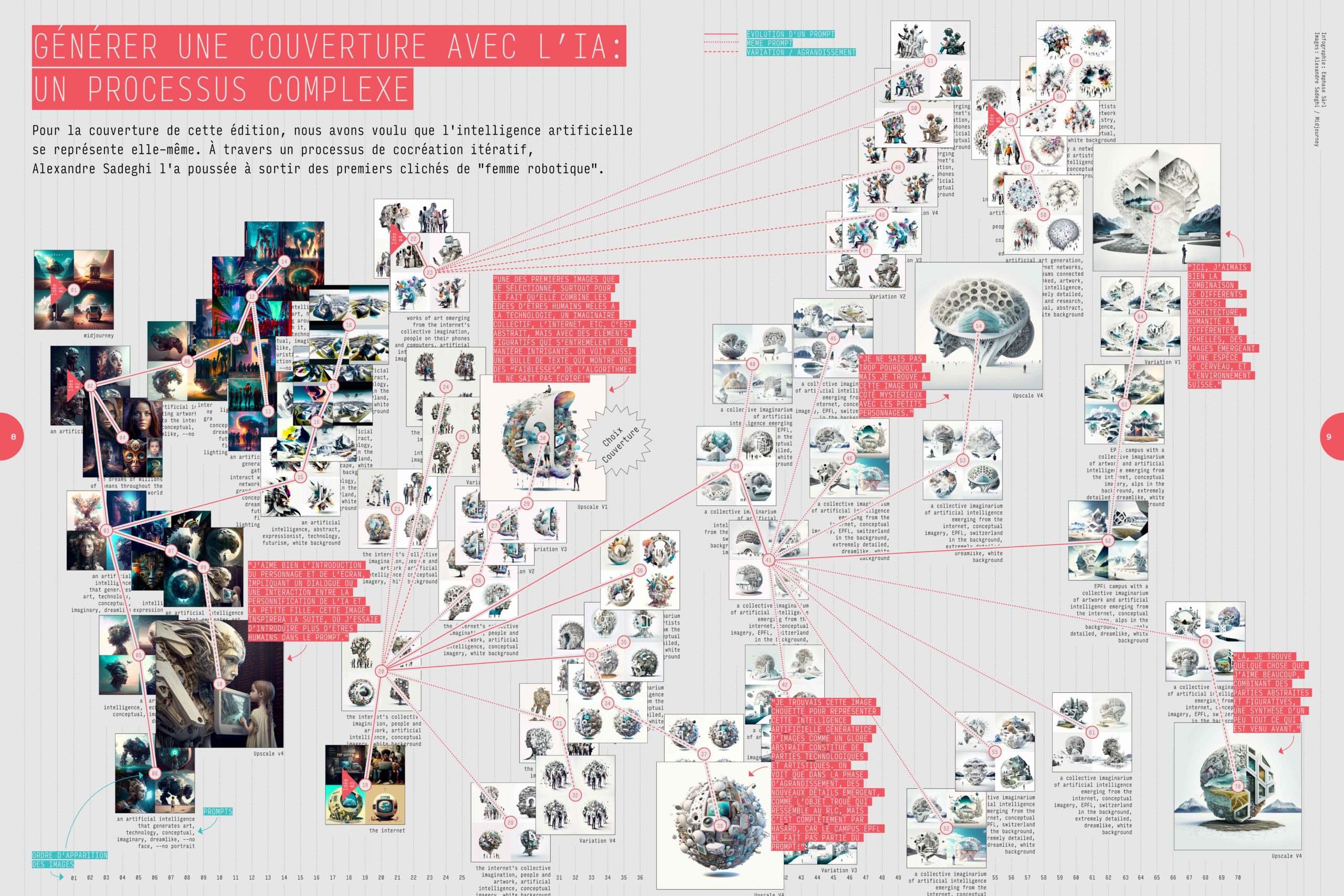

Démarche visuelle

Depuis son lancement, il y a bientôt deux ans, Dimensions fait appel à une illustratrice ou un illustrateur pour les images du dossier. Pour cette édition, nous n’avons pas failli au concept, toutefois nous avons choisi une personne qui utilise l’IA dans sa démarche artistique. Alexandre Sadeghi, assistant scientifique au Laboratoire de design et médias de l’EPFL, architecte, illustrateur et auteur, est à l’origine de ces images qu’il a générées à partir du programme Midjourney.

«Obtenir une image satisfaisante nécessite souvent des dizaines, voire des centaines d’itérations et variations, ainsi qu’autant d’affinements dans la formulation et le choix de langage du prompt. L’intention de l’illustrateur reste capitale, mais peut être influencée par des détours inattendus dans le processus, menant à des résultats issus d’une véritable cocréation entre humain et machine», explique le scientifique.

Chaque illustration est accompagnée d’un texte d’Alexandre Sadeghi, qui précise le prompt et commente la démarche et le résultat, ainsi que les hasards qui ont influencé les premières idées. Les images finales choisies englobent des styles et des techniques de prompt-crafting différents afin de témoigner de la flexibilité et de la puissance de programmes d’intelligence artificielle dans la génération d’images, mais aussi de leurs limites.

Dans une société où TikTok devient la principale source d’informations de nombreux jeunes, l’équilibre entre la qualité des informations obtenues et la forme sous laquelle elles sont présentées tend à pencher de plus en plus dangereusement vers la seconde.

Ce constat posé, l’ouverture au public de ChatGPT vient ajouter une couche d’inquiétude supplémentaire: «Lorsqu’on interroge cet outil, on obtient une réponse plausible et très bien formulée, relève Antoine Bosselut, responsable du Laboratoire de traitement du langage naturel de l’EPFL. Mais elle n’est pas précise, voire peut comporter de nombreuses contre-vérités. Sachant que la lecture critique des informations du web n’est pas la première qualité des jeunes internautes, il est légitime de s’inquiéter sur la façon dont ils et elles formeront leurs opinions à l’avenir.»

De prime abord, la recherche d’informations en langage naturel qu’offre ChatGPT a tout pour séduire. On l’interroge comme l’on demanderait à une connaissance bien informée, et l’on obtient une belle réponse. Mais plusieurs défauts – de conception ou de jeunesse – expliquent pourquoi il est impossible, voire dangereux, de s’y fier.

Pour commencer, «ChatGPT n’a aucune connaissance de ce qui est vrai ou faux, reprend Antoine Bosselut. Ses réponses sont construites sur la base de la probabilité que des mots s’enchaînent les uns avec les autres.» Il est du reste facile de «piéger» l’outil:

<Q>: Peut-on faire du thé avec de l’eauà 160 degrés Celsius?

<R>: Il est généralement recommandé de faire du thé avec de l’eau à une température inférieure à 100 degrés Celsius (212 degrés Fahrenheit). L’eau à 160 degrés Celsius (320 degrés Fahrenheit) est très chaude et pourrait brûler le thé, ce qui pourrait altérer le goût et les propriétés bénéfiques du thé. Il est préférable d’utiliser de l’eau entre 80 et 90 degrés Celsius (176 et 194 degrés Fahrenheit) pour faire du thé. Cela permet d’extraire les arômes et les propriétés bénéfiques du thé de manière optimale.

N’importe quel interlocuteur humain commencerait par répondre que l’eau ne peut pas atteindre cette température dans des conditions atmosphériques normales. ChatGPT, à l’inverse, est incapable de saisir l’incongruité de la demande – mais élabore une réponse très complète et détaillée.

Une autre raison pour laquelle le recours à ChatGPT dans l’utilisation quotidienne n’est pas pertinent réside dans le fait que son modèle de langage sous-jacent, GPT-3, dispose d’un nombre de paramètres certes ahurissant, mais que ses sources s’arrêtent en avril 2021.

À l’exception de corrections soufflées à l’outil par les utilisateurs eux-mêmes (car il a la capacité de les intégrer), aucune information plus récente n’y figure pour l’instant.

Enfin, voire surtout, ChatGPT livre des réponses dont la source n’est pas indiquée. Rachid Guerraoui, directeur du Laboratoire d’informatique distribuée de l’EPFL, s’inquiète: «Dans le cas d’une recherche sur Google, on obtient une liste et l’on peut choisir parmi les résultats celui qui provient d’une source à laquelle on fait confiance – un journal sérieux plutôt qu’un blog inconnu, par exemple. En revanche, face à une réponse complète et crédible rédigée en langage naturel, l’esprit critique est endormi et susceptible d’absorber n’importe quelle information, même fausse ou biaisée à des fins de propagande. C’est potentiellement très dangereux.»

Une course perdue d’avance

Avec ChatGPT, les intelligences artificielles (IA) deviennent un nouvel outil séduisant, parfois pertinent, et très accessible au grand public. «La nouveauté ne vient pas de ces modèles d’IA, qui ont déjà plusieurs années, mais de la perception de leur potentiel, souligne Antoine Bosselut. En s’ouvrant au grand public l’an dernier en version «bêta», OpenAI nous a en quelque sorte rendu service, car cela nous donne le temps de nous préparer à vivre dans un monde où ce type d’IA sera largement adopté, parce que beaucoup plus fiable.»

Ces robots interactifs pourraient en effet renouveler totalement la façon dont les utilisateurs accèdent aux informations du web. Aujourd’hui, 90% des requêtes sont formulées sur Google. Son principal concurrent, Microsoft, a lourdement investi dans OpenAI: aux milliards initiaux s’ajoutent au minimum une enveloppe de 10 milliards annoncée fin janvier, qui a permis au géant de Redmond d’annoncer l’intégration de ChatGPT dans son propre moteur de recherche, Bing, et sa suite bureautique Office. D’ici quelques semaines, c’est peut-être même la version 4 du modèle de langage GPT qui pourrait en être le moteur. Google n’a pas tardé à riposter, sortant ses fondateurs Larry Page et Sergey Brin de leur retraite pour se pencher sur la stratégie de riposte à adopter. Quelques semaines plus tard, la compagnie annonçait le lancement prochain de Bard, son propre chatbot.

Il n’en reste pas moins que de nombreuses questions devront encore être résolues. L’une des principales restant celle de la responsabilité. «On ne doit pas laisser à une machine la capacité de prendre une décision concernant un humain», insiste Antoine Bosselut. Une personne responsable, de chair et d’os doit pouvoir être désignée dans tout processus décisionnel. Or dans le cas d’OpenAI, les scientifiques sont face à une boîte noire. «On ne sait pas exactement quelles sont les sources de GPT-3, ni avec précision le fonctionnement de son algorithme. Plusieurs laboratoires de l’EPFL, dont le nôtre, essaient justement de le déduire en menant de nombreuses expériences, et travaillent à l’élaboration de systèmes plus transparents», explique-t-il.

La nouveauté ne vient pas de ces modèles d’IA, qui ont déjà plusieurs années, mais de la perception de leur potentiel”

Besoin de gouvernance

Le problème sous-jacent vient du fait qu’OpenAI – qui n’a d’open que son nom – est avant tout une société commerciale qui visera tôt ou tard à monétiser son service. Elle a d’ailleurs annoncé début février le lancement d’un service «premium» payant. La question de savoir comment Google et Microsoft comptent y retrouver leurs billes reste encore ouverte – mais la course est effrénée. Or elle ne se joue que dans la cour des géants, les GAFAM. «Il serait bien sûr préférable que de tels modèles de langage puissent être développés non pas par des privés, mais par la communauté scientifique. Hélas, nous n’avons pas les ressources pour pouvoir nous payer des machines capables de créer des modèles aussi performants», explique Rachid Guerraoui.

Selon nos experts, une forme de «gouvernance numérique» serait nécessaire pour éviter que ces services ne deviennent des outils de propagande ou de désinformation susceptibles de mettre en danger les démocraties. Au Forum économique mondial de Davos cette année, Martin Vetterli, président de l’EPFL, a plaidé pour la création d’une entente internationale dédiée à cette tâche – comparable aux accords établis au siècle dernier pour limiter la prolifération nucléaire. Un tel «gendarme de l’AI» pourrait par exemple imposer à chaque acteur d’assumer certaines responsabilités ou d’être transparent sur ses sources et ses algorithmes.

«L’une des caractéristiques les plus inquiétantes de ces modèles est leur capacité à amplifier certaines informations, reprend Rachid Guerraoui. S’il n’y a pas de contrôle de la véracité ou de la qualité des données qui sont fournies au modèle, des informations d’origine malveillante pourraient prendre le dessus.»

À l’EPFL, beaucoup de spécialistes s’affairent pour éviter ces dérives. L’initiative «SafeAI» (voir ci-dessus) développe des garde-fous techniques, des algorithmes concurrents qui compileront leurs résultats d’une manière qui évitera que des informations erronées ne puissent biaiser les résultats. «Reste qu’il faut pour cela un consensus sur la véracité des informations, prévient le chercheur. En fonction des visions du monde d’un Américain ou d’un Chinois, la même information pourra changer totalement de statut…»

Clairement disruptive, l’arrivée de cette version de ChatGPT – et l’imminence de celle de la prochaine, basée sur GPT-4, désormais annoncée pour ce début d’année encore – marque le début d’un profond changement de notre rapport aux outils numériques. De nombreux professionnels pourraient voir leur emploi menacé. D’autres, à l’instar du corps enseignant et des scientifiques, devront intégrer cette nouvelle réalité à leur cursus. D’autres enfin surferont sur les possibilités ainsi ouvertes pour développer de nouvelles activités ou de nouveaux services. Au-delà du buzz de ce début d’année, il y aura clairement un avant et un après ChatGPT. ■

Commentaire: Ici, le prompt très simple se structure en deux parties, l’une décrivant la scène et l’autre formée par des mots définissant le style. Cette image montre aussi comment le générateur écrit, en produisant des glyphes qui se rapprochent “statistiquement” de l’écriture, mais sont dénués de sens.

© Créé avec "Midjourney" par Alexandre Sadeghi

Éviter l’effet « caisse de résonance »

Il est relativement facile de tromper les algorithmes, ce qui ouvre la porte à toutes sortes de dérives malveillantes.

Une des faces obscures des algorithmes est qu’ils amplifient les biais. Si on y introduit des biais sexistes ou racistes, même sans mauvaise intention, comme la machine va beaucoup plus vite que nous et atteint beaucoup plus de monde, elle va faire office de caisse de résonance. Ce qui peut être extrêmement préjudiciable si les intentions sont malveillantes. Pour le démontrer, en avril 2022, l’émission ABE de la RTS avait ainsi créé un faux site de restaurant à Lausanne et avait réussi à le hisser parmi les 10 meilleures tables de la ville sur TripAdvisor en seulement 20 jours. «On peut fausser tous les classements très facilement», ne cache pas Rachid Guerraoui, professeur au Laboratoire de calcul distribué (LCD), qui avait commenté l’exercice.

Comment rendre les algorithmes plus sûrs? C’est un des axes de recherche du LCD, qui poursuit un programme baptisé SafeAI@EPFL. «Nous travaillons à ce que l’algorithme ignore des informations trop extrêmes, ce qui est possible tant qu’elles sont minoritaires. Imaginons que l’on cherche à mesurer la température sur Mars. Nous disposons de capteurs qui nous envoient des données entre -30 et -35. Nous arrivons à une température moyenne raisonnable. Mais si l’un des capteurs nous envoie une valeur de +1 million, la moyenne deviendra aberrante. Si l’on considère en revanche la médiane, la donnée aberrante sera ignorée ou en tout cas aura moins de poids. Nous cherchons donc à faire des algorithmes d’apprentissage qui s’inspirent plus de la médiane que de la moyenne.»

Aujourd’hui, la plupart des algorithmes commerciaux vont au plus simple et au moins coûteux, risquant de donner trop de poids aux extrêmes. «Mais à terme, la concurrence ou le manque de confiance pourrait inciter les exploitants à utiliser des algorithmes robustes tels que ceux développés à l’EPFL, même s’ils sont plus coûteux en termes de calcul.»

L’autre aspect sur lequel travaille l’EPFL concerne les données privées. Peut-on faire de l’apprentissage automatique tout en faisant que les données individuelles restent privées? «L’idée est d’anonymiser et de rajouter du «bruit» pour faire en sorte que les algorithmes apprennent ensemble sans violer la vie privée. Si tout le monde est honnête, ça va très bien. Mais dans le cas contraire, cela peut avoir des conséquences», prévient le professeur. ■ AMB

Commentaire: Ici, le prompt très simple se structure en deux parties, l’une décrivant la scène et l’autre formée par des mots définissant le style. Cette image montre aussi comment le générateur écrit, en produisant des glyphes qui se rapprochent “statistiquement” de l’écriture, mais sont dénués de sens.

© Créé avec "Midjourney" par Alexandre Sadeghi

Nous travaillons à ce que l’algorithme ignore des informations trop extrêmes, ce qui est possible tant qu’elles sont minoritaires”

Images: Alexandre Sadeghi / Midjourney

Images: Alexandre Sadeghi / Midjourney

Quelques semaines après son lancement mondial par OpenAI, ChatGPT a atteint 100 millions d’utilisateurs. Il devenait l’application grand public à la croissance la plus rapide de l’Histoire. Deux mois plus tard, Google annonçait la sortie de son IA Bard et, le jour suivant, Microsoft communiquait l’incorporation d’une nouvelle version de GPT dans Bing. Ces puissants programmes d’IA généralistes auront des répercussions sur à peu près tout, de l’éducation à l’emploi — ce qui a conduit le CEO d’OpenAI, Sam Altman, à prédire qu’ils entraîneront la chute du capitalisme. «Il est encore difficile de dire ce que cela représente pour l’humanité, le monde du travail ou nos interactions personnelles», commente Robert West, professeur assistant à la Faculté informatique et communications de l’EPFL.

Ce chercheur travaille sur le traitement du langage naturel avec des réseaux de neurones. Il les décrit comme le substrat des programmes d’IA généralistes. Ces dernières années, l’industrie s’est employée à les rendre de plus en plus massifs, avec une croissance exponentielle. GPT-3 (le modèle langagier central de ChatGPT) compte 175 milliards de paramètres dans son réseau neuronal, tandis que Google en aligne 540 milliards dans PalM. Selon les rumeurs, GPT-4 augmentera le nombre de paramètres de plusieurs ordres de magnitude.

Les dimensions de ces réseaux leur permettent d’effectuer des tâches autrefois inimaginables. Mais, en plus de leurs implications éthiques et sociétales, l’entraînement de programmes aussi massifs induit également des répercussions financières et environnementales.

En 2020 au Danemark, des scientifiques ont estimé que l’entraînement de GPT-3 avait requis une quantité d’énergie équivalente à la consommation de 126 foyers danois. L’empreinte carbone de 700’000 kilomètres en voiture.

Remuer la soupe

«Pour effectuer une simple addition, par exemple 48 +76, un modèle ultramoderne comme GPT-3 a besoin de l’intégralité de ses 175 milliards de paramètres. Avec «seulement» 6 milliards de paramètres, il accomplit un très mauvais travail et se trompe dans 90 % des cas», explique Robert West.

«La cause de cette inefficacité vient de ce que les réseaux neuronaux consistent encore en ce que j’appellerais une «soupe primordiale». Ce ne sont que de longues listes de nombres sans aucun type de structure. Je les considère comme des sortes de bouillons qui débordent de potentiel pour créer une structure», poursuit Robert West.

Son laboratoire de sciences des données s’est récemment vu décerner une Starting Grant du Fonds national suisse, dotée de 1,8 million de francs, pour tenter de résoudre un problème fondamental : transformer les milliards de données non structurées en représentations symboliques claires, grâce à des encodeurs automatisés.

«Dans les modèles de langage courants comme GPT-3, les connaissances sont diluées dans cette «soupe primordiale» de 175 milliards de paramètres. On ne peut pas ouvrir la boîte et accéder aux informations stockées. En tant qu’humains, nous ne savons pas ce que sait le modèle, à moins de lui poser la question. Nous ne pouvons donc pas facilement réparer les erreurs, parce que nous ne savons pas ce qui est erroné, explique Robert West. Nous allons appliquer le traitement du langage naturel autosupervisé du texte à la connaissance et dans l’autre sens. L’objectif est de proposer un nouveau paradigme pour un domaine appelé «traitement du langage naturel neuro-symbolique». Un peu comme si on apprivoisait la puissance brute des réseaux neuronaux en la canalisant à travers des représentations symboliques.»

Des neurosciences sur micropuce

Selon Robert West, cette approche ouvrira de nombreux possibles pour la prochaine génération d’IA, comme la correctibilité (en cas de mauvaise réponse il sera possible d’accéder au symbole et de le changer (dans une soupe de 175 milliards de paramètres, il est difficile de savoir où commencer)), l’équité (on pourra améliorer la représentation factuelle des femmes et des minorités, parce que l’information sera auditable) et l’interprétabilité (le modèle pourra expliquer pourquoi il est parvenu à une certaine conclusion, parce qu’il disposera de représentations explicites).

De plus, un tel modèle pourra raisonner de manière introspective et combiner des faits connus en faits nouveaux — ce que les humains font tout le temps. Il mémorisera et oubliera des faits simplement, en éliminant une entrée incorrecte de sa base de données.

«Quand on essaie de comprendre les modèles actuels les plus perfectionnés comme GPT-3, on mène en fait une étude neuroscientifique, en introduisant des sondes virtuelles pour tenter de comprendre où les faits sont représentés. Quand nous étudions un élément naturel, nous essayons de comprendre quelque chose que nous n’avons pas construit. Mais ces IA n’ont jamais quitté nos ordinateurs et pourtant nous ne comprenons pas même comment elles fonctionnent.»

Mettre à jour Wikipédia

La conclusion de cette recherche démontrera le vaste champ d’application de ces nouvelles méthodes, en les employant à révolutionner Wikipédia. Pour soutenir les éditeurs bénévoles, le nouveau modèle de Robert West s’attaquera à des tâches clés et les automatisera. Par exemple, il corrigera et mettra à jour les informations périmées et les synchronisera dans les 325 langues de la plateforme.

Robert West envisage aussi des avantages financiers et environnementaux au travail de son équipe. «À l’université, nous n’avons pas les ressources du privé. Notre meilleure chance réside donc dans un changement de paradigme plutôt que dans la poursuite de ceux qui existent déjà, explique-t-il. Je pense que c’est là que nous pourrons économiser des ressources en puissance de calcul, en étant plus malins quant à ce que nous utilisons et comment nous l’utilisons. L’industrie pourra reprendre nos méthodes et les implémenter dans ses propres modèles pour, à terme, les rendre plus économes en énergie et moins coûteux à exploiter.»

Pour le meilleur ou pour le pire, le génie est clairement sorti de la lampe avec ChatGPT. Robert West reste optimiste, quelle que soit la manière dont nous manœuvrerons face aux défis bien réels de l’avenir, avec des modèles d’IA généralistes qui évoluent à un rythme qui en a surpris plus d’un. Le chercheur puise l’intérêt pour son travail dans le fait qu’il le voit comme une manière de rompre les barrières de communication entre humains, mais aussi entre humains et machines.

«Ce n’est que le début. C’est déjà un défi technique, mais ce n’est vraiment qu’une étape vers quelque chose qui peut s’autoaméliorer de manière perpétuelle, avec de nombreux autres avantages.» ■

C’est déjà un défi technique, mais ce n’est vraiment qu’une étape vers quelque chose qui peut s’autoaméliorer de manière perpétuelle, avec de nombreux autres avantages”

Commentaire: Cet exemple montre un prompt plus avancé combinant plusieurs techniques visant, entre autres, à obtenir un résultat photo-réaliste. Différentes valeurs d’importance séparent les mots clés, ainsi que des indicateurs allant du style (Wes Anderson, 1970s photo) au modèle de caméra (Canon EOS 5D…). À noter en fin de prompt, l’utilisation de valeurs négatives que le générateur évitera.

© Créé avec "Midjourney" par Alexandre Sadeghi

« Je suis une machine »

En 1950, Alan Turing publie un article intitulé «Computing Machinery and Intelligence» qui pose déjà la question de savoir si les machines sont capables de penser. Mais devant l’impossibilité de répondre à cette question qui requiert de définir ce qu’est penser, le mathématicien britannique imagine un test beaucoup plus simple. Baptisé le «jeu de l’imitation», ce qui deviendra le test de Turing consiste à demander à un humain de distinguer un humain d’une machine, sans les voir mais en conversant avec eux à travers un outil conversationnel. Si la personne n’arrive pas identifier la machine sur la base des réponses reçues, l’IA a passé le test.

«ChatGPT est en train de réussir un peu ce test de Turing, même si l’on arrive à le piéger encore assez facilement», remarque Rachid Guerraoui, professeur au Laboratoire de calcul distribué de l’EPFL. «Ce qui est déroutant, c’est que dans 90% des cas, il donnera des réponses crédibles et assez justes. Évidemment quand on converse avec ChatGPT, on le sait, mais tout est fait pour rendre l’algorithme plus humain, à commencer par ses réponses qu’il semble écrire au fur et à mesure, en y prenant vaguement le temps alors qu’elles pourraient être affichées d’un seul tenant.»

Pour un enseignant qui reçoit le travail d’un élève, ou un client qui reçoit un e-mail, la détection est plus délicate. «Pour l’instant, le seul moyen de savoir que la production provient d’un programme est lorsque l’on trouve des contre-vérités ou les cas où il dit vraiment n’importe quoi», résume le professeur. À l’inverse, la présence de fautes d’orthographe ou de grammaire tendrait à prouver que l’auteur de la réponse est humain…

Une telle confusion n’est pas forcément à l’avantage du concepteur du programme. Nombre d’utilisatrices et utilisateurs pourraient préférer s’en détourner faute de transparence. À moins qu’il soit possible d’identifier clairement quand la production vient de la machine. «On pourrait imaginer un test de Turing inversé, dans lequel ce n’est plus l’humain qui doit détecter s’il s’agit d’un semblable ou d’une machine, mais qui identifie un texte, une image ou autre comme le fruit d’un algorithme», avance Rachid Guerraoui. ■ AMB

Commentaire: Cet exemple montre un prompt plus avancé combinant plusieurs techniques visant, entre autres, à obtenir un résultat photo-réaliste. Différentes valeurs d’importance séparent les mots clés, ainsi que des indicateurs allant du style (Wes Anderson, 1970s photo) au modèle de caméra (Canon EOS 5D…). À noter en fin de prompt, l’utilisation de valeurs négatives que le générateur évitera.

© Créé avec "Midjourney" par Alexandre Sadeghi

Prompt: A writer seeing a robot in their mirror, desk with typewriter::5 impressionism, monet, van gogh, expressionism, painting::4 brushstrokes, blue and yellow, wide brush ::3 grainy, deformed, cartoon, photography, animated, watermark::-2. Commentaire: Ici, la stylisation artistique est poussée par l’utilisation de noms d’artistes renommés, une technique répandue dans la génération d’images. Dans cet exemple, on voit comment le processus de cocréation peut mener à un résultat inattendu, car le visage émergeant de l’écran n’était pas prévu, mais m’a beaucoup plu pour illustrer la thématique de « fantôme dans la machine ». © Créé avec « Midjourney » par Alexandre Sadeghi

L’IA et l’apprentissage machine ayant trouvé leur place dans la recherche universitaire traditionnelle, on peut se demander comment Albert Einstein, Jonas Salk ou Alvar Aalto auraient pu utiliser ces puissants outils de calcul pour améliorer notre compréhension de la physique fondamentale, du développement des vaccins ou de la conception architecturale moderniste. En quelques années seulement, l’intelligence artificielle, qui a d’abord fait les gros titres en tant qu’ordinateur d’échecs surhumain, est parvenue à une maturité telle que n’importe qui peut lui poser une question et obtenir une réponse plausible, mais pas toujours fiable.

Mais que font exactement les chercheuses et chercheurs universitaires avec cette technologie? L’IA est-elle utile, devenue indispensable ou simplement une distraction? Pour le découvrir, nous avons examiné des projets de recherche en cours sur le campus de l’EPFL en architecture, sciences humaines, sciences fondamentales, sciences de la vie, ingénierie et informatique. Malgré les limites dont pâtit aujourd’hui l’intelligence artificielle, il s’avère que l’on est à l’aube d’une nouvelle ère de la recherche universitaire où l’on s’appuie non seulement sur les génies qui nous ont précédés, mais où l’on bénéficie également d’une aide fiable grâce aux bits, aux octets et aux réseaux neuronaux.

Contrôler le plasma dans un réacteur à fusion

Depuis des décennies, la fusion nucléaire nous annonce une énergie propre et pratiquement illimitée. Le Swiss Plasma Center participe à la progression de ce domaine en possédant l’un des rares réacteurs Tokamak opérationnels dans le monde. En 2022, les scientifiques se sont associés à DeepMind pour utiliser l’apprentissage par renforcement profond, une forme d’IA, pour contrôler et confiner le plasma dans lequel a lieu la réaction de fusion. L’IA a rapidement appris à configurer le système pour créer et maintenir diverses configurations de plasma. Problème résolu? Pas encore. Mais les progrès étaient… séduisants!

«Le contrôle des plasmas TCV à l’aide de l’apprentissage par renforcement a modifié mon opinion sur la façon de concevoir les systèmes de contrôle à l’avenir. Nous ne sommes qu’au début d’une nouvelle ère de la conception du contrôle. Les avantages seront immenses, non seulement pour la fusion, mais aussi pour de nombreux problèmes de contrôle difficiles à résoudre en ingénierie.»

Federico Felici, scientifique au Swiss Plasma Center.

Donner du sens à la langue

La communication n’est-elle pas une affaire de mots? Certainement. Mais est-elle sarcastique? Cynique? Affirmative? Dans le langage parlé, les gestes et le ton de la voix donnent un sens aux mots, en ajoutant des nuances qui se perdent à l’écrit. Le Laboratoire en musicologie numérique et cognitive a voulu savoir comment et pourquoi nous étions passés de significations continues à des mots discrets en demandant à deux agents virtuels d’échanger des signaux et d’améliorer leurs stratégies de communication grâce à l’apprentissage machine. Les conclusions ont permis de comprendre l’évolution des cartes de signification et la manière dont elles continueront à évoluer parallèlement à nos moyens de communication modernes.

La quintessence de l’architecture alpine

L’architecture alpine est le résultat de l’évolution culturelle, génération après génération, par des essais, des erreurs et des observations. Mais quelles sont les caractéristiques de conception qui ont découlé de ce processus et qui font qu’il est si bien adapté à la culture locale, à l’écologie et à l’environnement? Dans le cadre d’un projet de recherche mené par le Laboratoire de design et de médias, les étudiantes et étudiants ont soumis à des algorithmes d’IA, en particulier des réseaux neuronaux antagonistes génératifs, plus de 4000 images d’architecture alpine et, par un dialogue itératif avec l’IA, ont réduit les bâtiments à leurs caractéristiques basiques. L’intelligence collective homme-machine a ensuite interpolé les distributions de probabilité des éléments architecturaux qui en résultaient et a imaginé d’innombrables architectures alpines, qui ont été présentées au public dans plusieurs expositions interactives à travers le monde.

«L’association des capacités génératives et analytiques des machines et leur combinaison avec l’intelligence perceptive des êtres humains en une intelligence collective pourraient ouvrir la voie à des approches entièrement nouvelles de la conception des architectures et des villes du futur, où les frontières entre l’être humain et l’artificiel seront de plus en plus floues.»

Jeffrey Huang, responsable du Laboratoire de design et de médias de l’EPFL.

Prévoir les émissions polluantes des centrales de captage du carbone

Travaillant avec l’Université Heriot-Watt en Écosse, les scientifiques du Laboratoire de simulation moléculaire de l’EPFL ont mis au point une méthodologie basée sur l’apprentissage machine qui s’appuie sur de grandes quantités de données pour prédire avec précision le comportement de systèmes chimiques complexes. Les chercheuses et chercheurs ont utilisé cette approche pour prévoir avec précision les émissions d’amines des centrales de captage du carbone conçues pour rejeter le dioxyde de carbone capturé sous terre plutôt que dans l’atmosphère. Outre la réduction des émissions de ce polluant cancérigène par les centrales de captage du carbone, leurs recherches pourraient ouvrir la voie à de nouvelles pistes pour améliorer la durabilité des usines chimiques.

Monitorer le comportement des bouquetins dans les Alpes suisses

Le projet interdisciplinaire WildAI, avec l’IA comme élément central, vise à utiliser des capteurs à distance tels que des pièges à caméra pour modéliser la manière dont les espèces sauvages interagissent entre elles et avec leur environnement. Collaboration entre le Laboratoire de science computationnelle pour l’environnement et l’observation de la Terre, le Mathis Group for Computational Neuroscience and AI de l’EPFL et le Parc national suisse, il pourrait non seulement améliorer notre compréhension de l’impact de l’anthropocène sur la faune mais aussi permettre de découvrir de nouveaux processus écologiques qui sous-tendent les stratégies emblématiques sur la population de bouquetins dans les Hautes-Alpes.

«La promesse de l’intelligence artificielle dans ce domaine est double. En termes d’évolutivité, elle permet d’annoter automatiquement de vastes quantités de données de terrain, ce qui serait absolument impossible manuellement. Et en termes de découverte, des techniques telles que l’apprentissage non supervisé et la reconnaissance des formes peuvent décrire un écosystème donné très complexe, ce qui,

en retour, peut inspirer de nouvelles hypothèses axées sur les données à tester.»

Devis Tuia, professeur au Laboratoire de science computationnelle pour l’environnement et l’observation de la Terre.

Démêler les fondements de la vie

La vie telle que nous la connaissons repose sur une multitude d’interactions entre les protéines et d’autres biomolécules. Pourtant, nous commençons seulement à comprendre les mécanismes qui déterminent si et comment les protéines vont interagir entre elles. Outre la structure générale de leur surface, des facteurs tels que leurs propriétés chimiques et géométriques pourraient être des catalyseurs essentiels de ces interactions. Les chercheuses et chercheurs du Laboratoire de conception de protéines et d’immuno-ingénierie ont mis au point une méthodologie d’apprentissage profond géométrique permettant de classer les propriétés fonctionnelles des protéines et de prédire les interactions entre elles en se basant uniquement sur leur composition atomique. Leurs travaux promettent d’apporter de nouvelles informations sur la fonction et la conception des protéines.

ChatGPT serait une révolution, un saut quantique similaire à l’invention d’Internet. Il serait surtout la porte ouverte à toutes les tricheries: de quoi faire souffler un vent de panique dans les milieux de l’enseignement. Alors que de nombreux établissements débattent encore de la conduite à tenir, certains ont décidé de sévir. Voilà ChatGPT interdit, rangé entre les antisèches et la smart watch un peu trop smart. Les détracteurs du logiciel espèrent empêcher par la répression toute triche assistée par ordinateur.

À l’EPFL aussi, on suit de très près l’impact de ce nouveau logiciel, même si aucune interdiction n’est à l’ordre du jour. «Nous avons les mêmes préoccupations que tout le monde, comme la possibilité qu’un travail d’étudiant puisse être écrit par ChatGPT, mais nous voulons aussi comprendre en quoi cet outil va changer les besoins de la formation», réagit Pierre Dillenbourg, vice-président associé pour l’éducation à l’EPFL. Si une réflexion en profondeur lui semble indispensable, il estime qu’interdire le recours au logiciel est non seulement impossible «mais qu’il convient au contraire d’apprendre aux étudiantes et étudiants commet utiliser cet outil de manière appropriée.»

Testé lors des examens

Nombreux sont celles et ceux qui ont voulu tester ChatGPT à l’EPFL. Le professeur Martin Jaggi racontait ainsi sur le plateau d’Infrarouge que ChatGPT avait répondu avec brio aux questions d’examen de Master. Dans le cadre du cours «Ethics and Law of AI» de Johan Rochel, 17 étudiants sur 45 ont utilisé ChatGPT pour écrire un texte, principalement pour vérifier les arguments identifiés et obtenir un premier jet ou de nouvelles formulations. Directeur du Centre pour les sciences de l’apprentissage (LEARN) à l’EPFL, Francesco Mondada a pour sa part autorisé ChatGPT lors de son examen de robotique en janvier. «C’est un examen à livre ouvert, les étudiants ont déjà accès à tout le matériel pour répondre à des questions sur un cas particulier d’application de la robotique. Un quart de la classe a choisi d’utiliser ChatGPT. À partir des retours des élèves, on dirait que cet outil a surtout été utilisé dans les cas de doutes sur la matière apprise, alors que les étudiants qui ont renoncé à l’utiliser ont affirmé faire plus confiance à leurs capacités et craindre le manque de fiabilité de ChatGPT.» Francesco Mondada a lui-même employé ChatGPT pour préparer ses questions. «J’ai demandé à ChatGPT d’imaginer des cas possibles pour l’examen. La majorité de ses suggestions étaient semblables aux miennes, mais il a eu quelques bonnes idées. Je crois que c’est une des situations dans lesquelles ChatGPT est le plus utile.» Il a aussi posé les questions au logiciel en amont de l’examen, «pour voir si une question entraînait une réponse inattendue, et reformuler au besoin, afin que l’examen fasse appel aux bonnes connaissances.»

J’ai demandé à ChatGPT d’imaginer des cas possibles pour l’examen”

Esprit critique et compréhension globale

Après cette expérience, Francesco Mondada en est convaincu : mieux vaut former les étudiants pour une utilisation de ChatGPT à bon escient plutôt que chercher à le museler. Le centre LEARN s’est ainsi lancé dans la récolte de données sur l’utilisation de ChatGPT en classe et l’impact sur l’enseignement, notamment auprès des enseignants de plusieurs écoles postobligatoires. «L’arrivée de tout nouvel outil permet de se poser des questions fondamentales pour l’enseignement. Certaines réflexions auraient dû être amenées il y a 10 ans, avec Wikipédia ou les outils de traduction automatique par exemple. Le fait que tout le monde en discute maintenant, voilà probablement la meilleure contribution de ChatGPT!»

Outre des réflexions sur ce qu’on souhaite enseigner, par exemple l’esprit critique et la compréhension globale d’un problème plutôt que l’apprentissage par cœur, Francesco Mondada estime très important de se poser les bonnes questions dans l’utilisation d’un outil numérique. «Il faut savoir quelle est la nouveauté et comment fonctionne l’outil, pour mieux comprendre son potentiel et ses limitations : par exemple pourquoi ChatGPT va inventer des références totalement fausses.»

Commentaire: Un autre résultat inattendu, issu d’une longue recherche pour arriver à une image convaincante dans le style de Salvador Dalí. Par la modification progressive du prompt, l’image a finalement été générée sans aucune mention de l’artiste ou même du surréalisme, tout en maintenant une certaine qualité fantasmagorique et colorée.

© Créé avec "Midjourney" par Alexandre Sadeghi

Regarder sous le capot

Parmi les enseignants convaincus par ChatGPT, Martin Grandjean, spécialiste en humanités digitales à l’EPFL, estime lui aussi que le logiciel devrait rejoindre la boîte à outils de la recherche et de l’enseignement «pour que ces technologies soient comprises, critiquées et pourquoi pas utilisées dans des contextes spécifiques». Il propose par exemple d’utiliser ChatGPT en classe pour rédiger un texte sur le sujet étudié. «Ce serait un bon exercice de critique du logiciel et des sources à disposition sur Internet, en comparant le résultat à ce qu’on aurait pu faire avec une bonne connaissance du sujet. » Une approche qui permettrait aussi d’en relativiser les apports. «ChatGPT est un très bon bonimenteur, capable de nous faire croire qu’il a compris de quoi on parle, mais absolument incapable de faire remonter de l’information précise ou d’évaluer la pertinence de cette information par rapport à la question de départ.»

Mais si l’IA est faillible, la crainte de ses détracteurs est aussi que les futurs ingénieurs se reposent trop sur la machine et maîtrisent moins des savoirs de base. Au risque d’une formation au rabais. À cette remarque Martin Grandjean répond par une métaphore: «On ne juge pas les compétences d’un docteur en mathématiques à sa capacité à faire des opérations insensées sans calculatrice!» Il souligne que les outils d’intelligence artificielle feront sans doute bientôt partie de notre quotidien et qu’il est très important d’apprendre à les maîtriser. «Si les outils évoluent, il faut que les diplômés soient formés en conséquence, tout simplement. Cela n’implique pas seulement de savoir les utiliser, mais aussi de savoir comment ils fonctionnent, de pouvoir soulever le capot et en comprendre les rouages. Au fond, cela veut dire que les étudiants seront encore mieux formés qu’avant, parce qu’ils ne seront pas les opérateurs de ces «robots», mais réellement leurs concepteurs.» ■

Commentaire: Un autre résultat inattendu, issu d’une longue recherche pour arriver à une image convaincante dans le style de Salvador Dalí. Par la modification progressive du prompt, l’image a finalement été générée sans aucune mention de l’artiste ou même du surréalisme, tout en maintenant une certaine qualité fantasmagorique et colorée.

© Créé avec "Midjourney" par Alexandre Sadeghi

On ne juge pas les compétences d’un docteur en mathématiques à sa capacité à faire des opérations insensées sans calculatrice!”

L’épouvantail antiplagiat

Incorporer l’IA à l’enseignement est d’autant plus défendable qu’il est déjà trop tard pour l’interdire, selon les spécialistes. Les contre-mesures ayant toujours un train de retard face à des avancées technologiques fulgurantes, il n’est pas possible (pour l’heure) de prouver qu’un algorithme est l’auteur d’un texte. Car ChatGPT ne plagie pas à proprement parler, il crée des textes de toute pièce grâce à d’immenses bases de données de cooccurrences de mots. Résultat: il échappe à tous les outils de détection de plagiat. Pour contourner le problème, OpenAI, à l’origine de ChatGPT, pourrait incorporer un marqueur numérique repérable par un logiciel de détection. Des outils analysant le style spécifique de ChatGPT, comme le projet «GPTZero», sont aussi mis en avant, même si chaque version risque d’être rapidement dépassée.

Mais pour Francesco Mondada, directeur du centre LEARN à l’EPFL, l’emballement médiatique et les craintes autour de ChatGPT cachent une réalité plus nuancée : le plagiat à l’école est en réalité déjà difficile à détecter, malgré l’illusion de logiciels capables de repérer la copie. «Quand je demande aux enseignants s’ils utilisent systématiquement les outils détecteurs de plagiat, ils me répondent la plupart du temps que non, seulement en cas de doute», souligne Francesco Mondada. Qui poursuit: «On me dit aussi que les élèves savent que de tels programmes existent et que cela suffit à les décourager.» Plutôt épouvantails que véritables garde-fous, ces solutions sont loin d’être aussi infaillibles que le grand public l’imagine.

Certains estiment qu’un enseignant devrait pouvoir repérer le style trop parfait de ChatGPT, ainsi que sa tendance à juxtaposer des idées n’ayant aucun sens malgré leur apparence. Mais une utilisation habile du logiciel permet de lui donner un côté humain qui passera même le filtre d’une lecture attentive. «ChatGPT peut être ajusté pour donner des réponses très proches de celles d’élèves non experts dans le domaine. Je lui ai demandé de me formuler une réponse moins parfaite, comme le ferait un étudiant moyen, et d’y ajouter quelques fautes d’anglais», explique ainsi Francesco Mondada. Résultat: le logiciel a produit un texte indifférenciable d’une réponse composée par une étudiante ou un étudiant. Détecter l’auteur humain ou la machine à la lecture est donc quasiment impossible si chatGPT a été utilisé en tenant compte de ces paramètres. ■

Quand je demande aux enseignants s’ils utilisent systématique-ment les outils détecteurs de plagiat, ils me répondent la plupart du temps que non, seulement en cas de doute”

Comment pensez-vous que les IA génératives telle que Midjourney ou Stable Diffusion affecteront le travail des artistes?

Nous sommes à un moment charnière. Ces pratiques soulèvent de nombreuses questions éthiques et légales, intellectuellement très complexes. Mais globalement, je les considère comme une opportunité.

Pensez-vous que les artistes traditionnels partagent ce point de vue?

Pas tous, bien sûr. Je vois trois camps : le premier partage mes arguments, le deuxième se préoccupe surtout des problèmes d’atteinte au droit d’auteur, et le troisième, qui englobe de nombreux graphistes, a déjà vu quelques clients s’en aller, parce qu’ils sont satisfaits avec les résultats de l’IA générative.

Et donc, qu’est-ce qui sauvera ces artistes?

S’il y a une chose à laquelle les machines ne peuvent se substituer, c’est la créativité. Les nouveaux paradigmes esthétiques viennent de personnes qui créent et d’un public qui perçoit ces créations comme porteuses de sens. Les algorithmes seuls ne peuvent que copier, adapter et déformer des créations préexistantes. Par contre, les artistes et les intellectuels ont la considérable opportunité de développer de nouvelles formes d’art avec ces outils. Selon certains, ces derniers seraient aussi révolutionnaires que la photographie au moment de son invention — et les réactions de ceux qui les craignent sont très similaires à celles des peintres, qui pensaient que la photographie les tuerait. Et qu’avons-nous vu ? L’invention de nombreux nouveaux styles de peinture.

Que pensez-vous des productions de ces programmes?

Certaines applications sont vraiment impressionnantes, mais il reste beaucoup de problèmes à résoudre, à commencer par les sources que ces outils exploitent. Ils récoltent tous les contenus possibles sur le web. Certains sont soumis au droit d’auteur, d’autres peuvent inclure des matériaux dérangeants ou pornographiques. Cela soulève de sérieuses questions éthiques. Mais je suis surtout inquiète du manque de représentativité des sources utilisées. Ce qui est disponible publiquement sur Internet ne représente qu’une petite fraction de l’héritage culturel humain, et cela va renforcer de nombreux préjugés.

Est-il possible d’améliorer cette situation?

Oui. Dans mon laboratoire, par exemple, nous travaillons sur un ensemble de 200 ’000 heures de vidéo qu’on ne trouve pas sur Internet. Nous les analysons avec du machine learning, hors ligne, sur les clusters informatiques de l’EPFL. Nous utiliserons ces données pour développer des interfaces, qui mettront ces importantes ressources à disposition du public d’une manière innovante qui fera par exemple ressortir des valeurs affectives et émotionnelles.

Nous travaillons aussi avec l’héritage culturel de plusieurs pays de par le monde. Ceux qui ont la charge de ces collections sont sensibles à la réutilisation algorithmique de leurs matériaux, tout particulièrement les peuples des premières nations et les communautés natives. La souveraineté des données, la protection des savoirs sacrés et «l’IA native» constituent de profonds mouvements pour préserver les droits de ces groupes et démocratiser les algorithmes entraînés sur de fausses représentations. ■

Mais je suis surtout inquiète du manque de représentativité des sources utilisées”

Maintenant que l’humain conçoit des machines qui créent comme lui, on peut se demander à qui appartient la création de la créature. Au concepteur de la machine, à son utilisateur ou à la machine elle-même? En d’autres termes, qui est l’auteur d’une chanson à la Bob Dylan (qui a vendu ses droits d’auteur à Sony) pondue par ChatGPT ? Réponse: «On est encore trop souvent dans le flou», regrette Gaétan de Rassenfosse, titulaire de la Chaire en politiques scientifiques, technologiques et d’innovation à l’EPFL. «La problématique de la propriété intellectuelle concerne d’une part ce qui est créé à l’aide de l’IA (à qui appartient la création) et d’autre part le contenu existant employé pour entraîner les algorithmes (est-il protégé par le droit d’auteur ou autre et son utilisation est-elle conforme?). À ce jour, il est impossible de vérifier si l’algorithme de GPT3 a utilisé des éléments protégés par un copyright et dans quelle mesure.»

Les questions autour de la propriété intellectuelle (brevet et droit d’auteur) d’une invention ou d’une création générée par une IA prennent de l’ampleur. L’informaticien américain Stephen Thaler a éprouvé les bureaux de la propriété intellectuelle de par le monde: concepteur du programme d’IA nommé DABUS, Stephen Thaler a déposé des demandes de droits pour une invention générée par DABUS. Il a indiqué DABUS comme inventeur et précisé que l’invention avait été créée de façon autonome par une machine. Le bureau américain lui a refusé le brevet, justifiant que seuls les humains peuvent être inventeurs. Il vient de faire appel. Mais d’autres bureaux ont accordé le brevet, ajoutant à la confusion.

«À l’avenir, l’avantage compétitif dans l’innovation passera des personnes les plus performantes aux outils les plus performants», assure Julian Nolan, CEO d’Iprova. Installée sur le campus de l’EPFL, cette société a mis au point une plateforme d’aide à la génération d’inventions basée sur les données, l’apprentissage automatique et le traitement automatique du langage. Iprova cède les droits de propriété intellectuelle au client s’il accepte l’invention.

Peut-on délivrer un brevet si une machine est l’inventeuse? Et de façon normative, faudrait-il autoriser les brevets sur des inventions autonomes? Sachant que, quand on délivre un brevet, on donne l’exclusivité sur une invention pour 20 ans, «donner un brevet à une invention autonome, c’est un peu donner de la propriété intellectuelle à une machine», remarque Gaétan de Rassenfosse.

«Si l’on considère l’IA comme un outil, au même titre qu’un microscope, alors une invention est brevetable», poursuit le professeur. Mais jusqu’à quel degré considère-t-on l’intervention humaine? Y a-t-il eu une activité créative d’un humain? Ou l’activité créative vient-elle de la machine – l’humain devenant alors en quelque sorte son outil?

Un cadre législatif à définir

«De telles questions sont en train d’être débattues, notamment par la Commission européenne, qui est en avance sur d’autres pays dans le domaine législatif, confirme le chercheur. Le résultat mais aussi la façon dont d’autres pays (les États-Unis, la Chine notamment) y répondront seront déterminants. Pour les start-up notamment, car ce cadre réglementaire va contraindre la manière dont les entreprises vont utiliser les données pour entraîner leurs algorithmes. Or on sait que ces derniers sont plus performants s’ils sont entraînés sur une grande masse de données. Si l’on met trop de barrières réglementaires, les start-up européennes pourraient être désavantagées par rapport aux américaines, qui auraient accès à des données dans un cadre réglementaire plus souple.»

Gaétan de Rassenfosse pense que la balance va pencher en faveur du brevetage des inventions autonomes. «Car, en pratique, il serait extrêmement difficile de prouver qu’une invention est véritablement issue d’une machine et non d’un humain.» Mais autoriser les brevets sur ce type d’inventions n’est pas sans risque. «À partir du moment où inventer devient meilleur marché, plus facile et plus rapide, on pourrait en théorie inonder le marché d’inventions et de brevets , imagine Gaétan de Rassenfosse. Déposer de nombreux brevets reviendrait trop cher et serait trop fastidieux, mais une grosse entreprise des GAFAM pourrait parfaitement générer 1 million d’inventions dans la téléphonie mobile – dont une grande partie sera certes farfelue – et les mettre dans le domaine public. Elle empêcherait ainsi toutes les autres entreprises de breveter une de ces inventions. Au risque de casser le marché.» ■

Il serait extrêmement difficile de prouver qu’une invention est véritablement issue d’une machine et non d’un humain”

Et si tout commençait par ces deux mots: intelligence artificielle (IA)? «Un magnifique coup de marketing de chercheurs dans les années 50!» estime Johan Rochel, chercheur en droit et en éthique de l’innovation et chargé de cours à l’EPFL. L’expression sous-entend qu’il y a plusieurs sortes d’intelligence et l’humain se retrouve en compétition avec celles-ci. Si l’on parlait plus prosaïquement d’algorithmes, l’humanité se serait peut-être moins sentie menacée par cette autre «intelligence» qui nourrit les fantasmes de domination les plus farfelus. Car d’intelligence il n’est point question. La parole des algorithmes n’est que mathématique. Les machines ne pensent pas par elles-mêmes. Alors pourquoi nous font-elles peur?

Pour Johan Rochel, une des réponses tient justement au récit que l’on promeut. «Il y a deux sortes de narratifs qui soulèvent chacun d’importantes questions éthiques. Soit on est dans un scénario de compétition entre l’humain et la machine avec les histoires de science-fiction dans lesquelles les robots vont prendre le contrôle. Récit qui nourrit l’idée de menaces de tout ordre, y compris sur le marché du travail. Soit on considère que les machines sont des instruments au service de l’humain. Au même titre qu’une voiture sert à se déplacer. Ou la calculatrice permet de calculer plus vite. Peu de gens diraient aujourd’hui que la calculatrice nous menace.»

Un outil bientôt universel

Selon que l’on est un syndicat ou une entreprise de la Silicon Valley, on aura intérêt à pousser l’un ou l’autre récit narratif. Individuellement, on fait de même plus ou moins consciemment, au gré des influences et du tapage médiatique. «Le buzz orchestré par OpenAI, concepteur de ChatGPT, est un formidable coup de communication. Comment résister à cette frénésie? Il en va quasiment du sens de l’histoire, faisant passer les critiques pour des nuls!» analyse Johan Rochel.

Fondamentalement, ChatGPT ne soulève pas de nouvelles questions éthiques que ne posait pas déjà de façon générale l’IA, estime le chercheur. En revanche, la démocratisation inédite de l’outil les rend tangibles puisque tout un chacun peut en mesurer la puissance. Avec quels impacts sur nos sociétés? En concevant un programme qui crée et génère du contenu textuel – et on parle déjà de sons et de vidéos – ChatGPT touche quasiment tous les domaines d’activité. Rares sont celles et ceux qui n’y trouveront pas un coup de pouce pour par exemple écrire un petit rapport, une lettre ou un e-mail. Quel en sera l’impact sur les rapports de travail? «Longtemps, un travail intéressant a été lié à la création de contenu, répond Johan Rochel. Désormais, la distinction entre l’impact sur les métiers manuels vs les métiers intellectuels disparaît. Comment cela va-t-il modifier notre travail? Qui prendra en charge ce changement? Est-ce à l’employeur d’offrir une formation à l’employé? À l’État?»

Le buzz orchestré par OpenAI, concepteur de ChatGPT, est un formidable coup de communication”

En investissant de plus en plus de domaines professionnels, la machine pourrait-elle prendre une place qui nous dépasse? Elle peut déjà poser des diagnostics plus fiables que des médecins. Un jour viendra-t-il où les assurances refuseront de rembourser les patients qui recourent à des professionnels en ignorant le programme? «En fin de compte, l’IA nous force à nous demander ce qu’est un bon juge, une bonne médecin, un bon graphiste, une bonne journaliste… Il doit se redéfinir en fonction de la machine. Une bonne juge est peut-être celle qui est capable de bien utiliser la machine tout en assumant de prendre une décision contraire à la recommandation informatique? Un bon programmeur est-il celui qui sait utiliser l’outil de manière responsable?»

Autre question éthique annexe, mais tout aussi cruciale, celle de la responsabilité. «Cette question va être la porte d’entrée de la régulation. Aujourd’hui, on ne peut pas laisser les voitures autonomes aller sur la route tant qu’on n’a pas réglé la question de la responsabilité. Les enjeux financiers sous-jacents, par exemple pour les assurances, exigent une régulation, sachant que l’outil n’est jamais responsable. Il n’a pas de capacité à décider pour lui-même, n’a pas d’autonomie. Il faut chercher l’humain derrière la machine. La question de la répartition des responsabilités est d’autant plus difficile quand il s’agit d’un outil qui apprend au cours de son utilisation. Qui décidera de cette allocation des responsabilités? L’industrie? Les politiques?»

Commentaire: Cette image, qui combine deux générations séparées, montre la puissance de tels outils de cocréation lorsqu’ils sont associés à des méthodes, workflows et outils préexistants. En effet, générer du code informatique dans le style « Renaissance » s’est avéré difficile, j’ai donc généré la scène et le code séparément, les combinant par la suite dans un éditeur d’image en y corrigeant quelques petits détails à la main.

© Créé avec Midjourney par Alexandre Sadeghi

Gênante « boîte noire »

Le troisième aspect de l’éthique de l’IA est lié aux mystères de la boîte noire des algorithmes. Comment, sur la base d’une question ou d’un prompt, le programme a-t-il généré cette réponse? Dans un système complexe, il est parfois impossible de le savoir. Or s’il s’agit d’un jugement ou du refus de l’octroi d’une hypothèque par exemple, il peut être nécessaire de savoir comment la machine en est arrivée à générer cette réponse. A-t-elle subit des biais? Lesquels? «Ce sera sans doute un gros facteur de blocage pour faire avancer ces technologies, estime le chercheur. Tant qu’on ne pourra pas expliquer ce qui se passe dans la machine, on n’ira pas plus loin dans certains domaines sensibles.»

Dans le cas de ChatGPT, savoir comment se construit une réponse est déterminant pour la comprendre et l’interpréter, sachant que l’outil n’a aucune ambition de dire la vérité, ne fait qu’agréger des mots en utilisant la plausibilité de l’occurrence d’un mot dans un contexte particulier. La structure et la syntaxe sont importantes pour la plausibilité, mais le programme ne comprend rien. Du point de vue de l’utilisateur mal informé, ça ressemble à Google ou Wikipédia, mais les objectifs et le fonctionnement de ChatGPT sont diamétralement différents. Le risque de manipulation des opinions s’en retrouve renforcé. Plus encore qu’avec les réseaux sociaux.

«Ça présente bien, mais l’emballage rend le contenu plus dangereux», prévient Johan Rochel, qui voit là un réel danger, pour la démocratie. Et d’expliquer: «Les médias sont moins concernés, car ils ont des règles déontologiques et des standards à respecter. Mais d’autres branches, politiques ou lobbyistes, n’en ont pas et entretiennent un rapport plus distendu avec la vérité… Imaginez ce genre d’outil utilisé par des climatosceptiques! ChatGPT répond, argumente et dit ce pour quoi on l’a programmé. Cette discussion a commencé avec les deepfake. On a désormais abandonné l’idée qu’une photo ou un film, parce qu’ils existent, reflètent la réalité. On va maintenant faire une expérience similaire avec les textes et les outils d’interaction qui écrivent ou parlent comme un humain.»■

Commentaire: Cette image, qui combine deux générations séparées, montre la puissance de tels outils de cocréation lorsqu’ils sont associés à des méthodes, workflows et outils préexistants. En effet, générer du code informatique dans le style « Renaissance » s’est avéré difficile, j’ai donc généré la scène et le code séparément, les combinant par la suite dans un éditeur d’image en y corrigeant quelques petits détails à la main.

© Créé avec Midjourney par Alexandre Sadeghi